Als Menschen verbringen wir den größten Teil unseres Tages damit, mit Benutzeroberflächen (UIs) zu interagieren. Die primäre Schnittstelle, die wir täglich verwenden, vielleicht eher alle paar Minuten: unsere Telefone. Smartphones und ihre Touchscreen-Schnittstellen haben die Funktionsweise anderer Geräte beeinflusst, die wir erwarten. Wir haben eine neue Reihe von Standarderwartungen und es ist leicht, enttäuscht zu werden, wenn die Benutzeroberfläche nicht einfach zu bedienen ist.

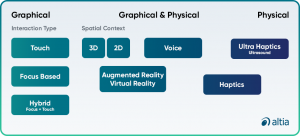

In einem vergangenen Blogbeitrag Erkundung des UI-Universums: Verschiedene Arten von UIhaben wir UI definiert und vier gängige Typen von Benutzerschnittstellen identifiziert. Während dieser Inhalt wahr bleibt, bringt die neue Technologie neue Kategorien und Überlegungen mit sich. In diesem Artikel stellen wir aktualisierte UI-Typen vor, die unter die Oberbegriffe grafische Benutzeroberflächen (GUIs), physische Benutzeroberflächen und Hybridmodelle fallen.

Unsere Endbenutzer erwarten, dass UIs intuitiv und effizient sind. Als Ingenieure oder Designer muss unsere Benutzeroberfläche für den Endbenutzer funktionieren, egal welches gerät. Wenn wir Benutzeroberflächen entwerfen, müssen wir auch für die Benutzererfahrung (UX) entwerfen. UI informiert UX und wiederum UX informiert UI. Wir wollen, dass der Benutzer es macht wirklich Spaß, das Produkt zu verwenden. Die Benutzeroberfläche muss nicht nur gut aussehen, sondern die Interaktion muss dem Endbenutzer das Gefühl geben, produktiv und erfolgreich zu sein.

Berühren Sie die Benutzeroberfläche

Touchscreens haben zu diesem Zeitpunkt Tausende, wenn nicht Millionen von Produkten und Benutzeroberflächen überholt. Die UX ist jedoch für diese Benutzeroberflächen unverzichtbar geworden. Für Krankenschwestern und medizinisches Fachpersonal haben Touchscreens begonnen, Knöpfe und Knöpfe zu ersetzen.

Die meisten Benutzerschnittstellen von Beatmungsgeräten sind jetzt mit Touchscreens ausgestattet durchdachte und rigoros getestete Sicherheitsmodi. Beispielsweise das Platzieren kritischer Schaltflächen am unteren Rand des Bildschirms für einen schnellen Zugriff, zweimalige Aufforderung zur Bestätigung eines Befehls oder Aufforderung an den Benutzer, eine Schaltfläche auf dem Bildschirm gedrückt zu halten, um diesen Befehl auszuführen.

Nicht nur die eigentlichen Touchscreen-Tasten sind wichtig, sondern Farben sind in medizinischen Situationen noch wichtiger. Krankenschwestern und Ärzte müssen schnell auf den Bildschirm eines medizinischen Geräts schauen und anhand der Farbe erkennen, was vor sich geht. Der Blutdruck ist rot, die Sauerstoffsättigung blau und wenn ein Patient atmet, wird er grün angezeigt. Diese Bildschirme müssen in der Lage sein, wichtige Informationen auf einen Blick zu vermitteln, damit der Benutzer schnell reagieren kann, indem er den richtigen Befehl drückt.

Fokusbasierte Benutzeroberfläche

Wenn wir an fokusbasierte Benutzeroberflächen denken, fällt uns normalerweise ein Computerbildschirm ein. Der Benutzer verwendet eine Maus oder einen Cursor, um mit dem Produkt und seinem Bildschirm zu interagieren. Der Cursor zeigt dem Benutzer die aktuelle Position für die Benutzerinteraktion, sodass der Benutzer eine Aktion ausführen kann und das Gerät auf diese Eingabe reagiert.

Unabhängig vom Gerät muss der Cursor oder Zeiger groß genug sein, um gesehen zu werden – kein Schielen erforderlich. Es muss auch den Hintergrund auf den verschiedenen Bildschirmen kontrastieren, damit er mit bloßem Auge nicht verloren geht. Was wir bei fokusbasierten Schnittstellen immer häufiger sehen, ist eine Mischung aus einem Cursor mit Berührung, sodass der Benutzer seinen Finger verwenden kann, um den Cursor oder Zeiger zu bewegen.

2D- und 3D-Benutzeroberflächen

In der 2D-Welt einer digitalen Anzeige fügen 3D-Benutzeroberflächen zusätzlichen Kontext und Details hinzu. In einem High-End-Automobil-Cluster informiert das 3D-Statusauto den Fahrer beispielsweise darüber, welcher Reifen zu wenig Druck hat oder welche Tür noch offen ist, was den Komfort und die Effizienz wirklich optimiert. Altia ermöglicht es Entwicklern Integrieren Sie 2D- und 3D-Grafiken für benutzerdefinierte eingebettete Displays.

Für die medizinische Industrie, während Ultraschall immer noch in 2D ist, wird eine 3D-Ansicht eines Patienten einen Arzt darüber informieren, wo er Sensoren platzieren oder ein Organ aus einem anderen Blickwinkel betrachten kann. Herz- und Gefäßchirurgen können die 3D-Technologie nicht nur zum Bau von 3D-Herzen verwenden, sondern auch Innenansichten des Herzens und potenzielle Defekte sehen – und letztendlich Leben retten, indem sie eine visuelle UI-Verbesserung hinzufügen.

Augmented Reality und Virtual Reality

Wir sehen, dass sich Augmented-Reality- (AR) und Virtual-Reality-Technologien (VR) schnell weiterentwickeln und aus der Notwendigkeit heraus zum Mainstream werden, insbesondere in Bildungseinrichtungen und im Gesundheitswesen. Während diese Begriffe super trendy sind und normalerweise zusammen gruppiert werden, ist es wichtig zu wissen, wie sich AR und VR unterscheiden. AR verbessert das, was Sie im wirklichen Leben sehen, mit zusätzlichen Informationen und Grafiken, während VR eine andere digitale Umgebung schafft, die das, was der Benutzer als seine „reale Welt“ sieht, vollständig ersetzt.

Das Gesundheitswesen wird visueller werden, und GUIs werden dies ermöglichen. Von Lernsituationen bis hin zu lebensrettenden Operationen können AR und VR implementiert werden, um die Erfahrung zu verbessern.

Operationen werden bereits laparoskopisch durchgeführt, wobei der Arzt an einem Schreibtisch mit einem Bildschirm sitzt – AR würde nicht nur die UX, sondern auch die Sichtbarkeit verbessern. Währenddessen müssen medizinische Geräte sein sicher, genau und einfach zu bedienen in kritischen Situationen. AR/VR werden nicht nur für medizinische Geräte wertvoll sein, sie werden auch für Head-up-Displays in Autos, Lastwagen, SUVs und sogar Geländefahrzeugen von entscheidender Bedeutung sein.

Sprach-UI

Sprachschnittstellen ermöglichen es dem Benutzer, mit einem Produkt durch Sprache oder verbale Befehle zu interagieren. „Hallo Siri" und "Hey alexa“ sind für die meisten Menschen zu bekannten Phrasen geworden, auch wenn sie keinen dieser virtuellen Assistenten besitzen. Eine Einkaufsliste herunterrasseln, einen neuen Song anfordern, um Erinnerungen bitten – alle Benutzerinteraktionen basieren auf Sprache und werden ausgeführt, wenn die Notwendigkeit im Vordergrund steht.

Am häufigsten sehen wir Sprachschnittstellen sowohl als grafische als auch als physische Benutzeroberflächen, da häufig eine Teleprompter-Benutzeroberfläche verwendet wird, um dem Benutzer Feedback und Eingabeaufforderungen zu geben. Eine Sprachschnittstelle ist ein echtes Ergebnis des UX/UI-Designs, da sie den Sprachbefehl hören und verstehen muss dann die Aktion abschließen. Wir sehen Voice UX mehr als je zuvor und es gibt jetzt kein Halten mehr.

Haptik und Ultrahaptik

Haptik sind Technologien, die ein Erlebnis schaffen, das der Benutzer physisch fühlen kann, indem sie den Tastsinn aktivieren – denken Sie an ein Summen oder Vibrieren, wenn Sie Ihr Passwort falsch eingeben oder Ihr Fingerabdruck nicht genau richtig landet, um Ihr Gerät zu entsperren. Haptik gibt dem Benutzer ein klares Gefühl von Erfolg oder Misserfolg während der Interaktion.

Für die Automobilindustrie kann die Haptik eine verstärkte Interaktion mit dem Fahrzeug ermöglichen, ohne die Sicherheit zu opfern. Wenn der Fahrer eine Benachrichtigung fühlen und schnell reagieren kann (auch mit Sprache oder Gesten), anstatt den Blick von der Straße abzuwenden, sind alle rundum sicherer. Haptik ermöglicht es Ihren Benutzern, mit Ihrem Produkt auf eine Weise zu interagieren, die sie fühlen können, anstatt sie zu sehen.

Ultrahaptik ermöglicht Interaktionen mit Objekten in der Luft mithilfe von Ultraschall, der Luftdruckwellen von der Hand eines Benutzers reflektiert. Produkte mit ultrahaptischen UIs erwecken die Illusion, dass Endbenutzer tatsächlich Objekte in der Luft fühlen, und ermöglichen es ihnen, mit einem Objekt auf einem Bildschirm zu interagieren.

Hybridmodelle

Was Sie immer häufiger sehen werden, sind hybride Benutzeroberflächen, die eine Kombination aus Modalitäten und Interaktionen beinhalten. Während die Sprache funktionieren kann, wenn ein Benutzer allein und an einem ruhigen Ort ist, sind Gesten- oder Berührungsschnittstellen in einer öffentlichen Umgebung bequemer und weniger aufdringlich. Darüber hinaus kann der Benutzer auf einer Baustelle möglicherweise keine Sprache verwenden, aber er kann einen Bildschirm berühren, um durch die digitalen Baupläne zu blättern. Für die Medizinbranche können gestenbasierte oder sprachgesteuerte Benutzeroberflächen eine bessere Option sein, wenn ein medizinisches Fachpersonal Handschuhe trägt.

Grafische Benutzeroberflächen können nicht nur einfach zu bedienen und intuitiv sein, sondern diese Arten von Benutzeroberflächen – insbesondere berührungsempfindliche und haptische Benutzeroberflächen – sind auch das, was Endbenutzer erwarten. Hybride Benutzeroberflächen mit Touch- und 3D-Funktionen können Produktunterscheidungsmerkmale sein, die nicht nur Ihren Endbenutzer beeindrucken, sondern letztendlich ein unglaubliches Benutzererlebnis ermöglichen.

Fazit

Letztendlich möchten Sie eine Balance zwischen Innovation und Funktion finden. Während die Idee von auffälligen und hochdetaillierten Grafiken auf Ihrer Benutzeroberfläche in einer Brainstorming-Sitzung großartig klingt, ist es manchmal umso besser, je einfacher es ist. Sie wollen eine Benutzeroberfläche entwerfen Dadurch kann ein Endbenutzer seine Arbeit intuitiv erledigen, sei es bei der Durchführung eines komplizierten medizinischen Eingriffs oder beim Starten einer Waschmaschine.

Die Zukunft der Benutzeroberfläche ist unglaublich spannend. Derzeit sind Innovationen in Arbeit, die herkömmliche Oberflächen wie eine Auto-Armlehne in eine UI-Steuerung verwandeln. Technologien wie leitfähige Fäden, Mechatronik und intelligente Materialien werden es Unternehmen ermöglichen, UIs zu entwickeln, um futuristische Benutzererfahrungen zu schaffen.

Mit dem modellbasierten Entwicklungsansatz von Altia erhalten Sie die Möglichkeit, ein benutzerdefiniertes Benutzeroberflächenmodell in zu erstellen Altia-Design, unser GUI-Editor. Diese Modelle ermöglichen eine klare Kommunikation, schnelles Feedback und Iterationen für Ihr UI-Design. Die Software von Altia ermöglicht das Testen mit Benutzern in realen Anwendungsfällen während des gesamten Entwicklungsprozesses – sowohl in einer Laufzeitumgebung als auch im Test Hardware– um sicherzustellen, dass die UX Ihrer Benutzeroberfläche die Erwartungen Ihrer Endbenutzer in Bezug auf Leistung, Funktionen und Benutzerfreundlichkeit erfüllt. Sobald Ihre GUI perfektioniert ist, Altia DeepScreen generiert optimierten, zertifizierbaren C-Code für Ihre Produktionshardware, damit Sie Ihre beste UX vom Konzept bis zur Produktion schnell, effizient und erfolgreich erhalten.

Vom für UX optimierten Grafikdesign bis hin zu Prototypen und Tests, wir können alles. Kontaktieren Sie uns für eine kostenlose Demo